Привет, коллеги! Сегодня мы разберемся с тем, как нейросети Google и Яндекса превратились в «Ищеек», которые вычисляют манипуляции с трафиком. Если раньше накрутка кликов или времени на сайте работала, то в 2025 году алгоритмы видят подвох за 3 секунды, но к сожалению, Яндекс ничего с этим не делает. Не переживайте — я расскажу, как защитить сайт и остаться «чистым» в глазах ИИ.

Как нейросети ловят мошенников?

Алгоритмы анализируют паттерны поведения, которые неестественны для живых пользователей:

- Слишком быстрые клики (например, 100 переходов за минуту с одного IP);

- Идеальная глубина просмотра (все посетители читают ровно 5 секунд);

- Шаблонные пути (последовательность «главная ? товар ? корзина» у 95% «пользователей»).

Пример из практики: Один из клиентов, до работы с нами, накручивал время на сайте через ботов, имитирующих чтение статей по 10 минут. Нейросеть Google обнаружила аномалию — реальные люди редко читают контент дольше 3-4 минут без пауз или скролла. В результате — трафик упал на 70%

Чем это полезно обычным людям?

- Меньше фейковых отзывов. ИИ-детекторы удаляют накрученные 5 звезд у сомнительных товаров.

- Более честный поиск. Сайты с накруткой не попадают в ТОП, а значит, вы видите только полезные ресурсы.

- Защита от спама. Боты больше не смогут массово оставлять комментарии с рекламой в блогах

Как вебмастерам избежать блокировки? 5 стратегий

Забудьте о «серых» методах. Накрутка через Telegram-ботов, арбитраж трафика с мусорных сайтов или покупка «мертвых» переходов — теперь это русская рулетка. Даже если алгоритм не заметит подвох сразу, позже ваш сайт может попасть под фильтр.

Улучшайте реальные поведенческие метрик.

- Добавьте интерактив: калькуляторы, тесты («Какой тип SEO подходит вашему сайту?»), чек-листы для скачивания.

- Внедрите видеоинструкции — их досматривают до конца в 3 раза чаще, чем тексты.

- Разбейте статьи на блоки с прогресс-баром («Прочитано 20%») — это увеличивает время сессии.

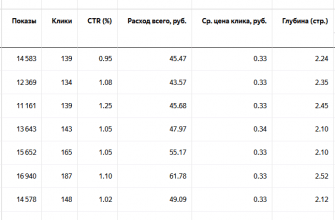

Анализируйте трафик через призму ИИ. Используйте инструменты, которые симулируют работу алгоритмов-детекторов:

- Hotjar Recordings — смотрите записи сессий: если 90% посетителей скроллят страницу одинаково — это подозрительно.

- Вебвизор от Яндекса отличный инструмент, где даже не специалист может получить полную картину по трафику.

- Google Analytics 4 с ИИ-поиском аномалий — ищите странные пики трафика.

- Botometer — проверяйте, не маскируются ли боты под реальных пользователей.

Работайте с микроцелевыми аудиториями. Чем уже ваша ЦА, тем естественнее их поведение. Пример:

- Вместо таргета «Все, кто любит спорт» ? «Мужчины 30-45 лет, участвующие в марафонах, с доходом 100k+».

- Такие пользователи детально изучают контент, оставляют осмысленные комментарии и реже «сбегают» за 5 секунд.

Тестируйте контент через нейросети. Сервисы вроде Surfer AI или MarketMuse показывают, насколько ваш текст соответствует ожиданиям реальных людей (а не SEO-роботов). Если ИИ оценивает статью как «шаблонную» или «переоптимизированную» — перепишите ее.

Чек-лист для экстренной защиты

Для пользователей: проверяйте сайты через WHOIS — если домену меньше 3 месяцев, а отзывов тысячи, это красный флаг.

Для вебмастеров:

- Удалите ссылки с «мусорных» доноров через Ahrefs Disavow Tool.

- Настройте CAPTCHA для форм комментариев и регистраций.

- Запустите A/B-тесты для главных страниц — это «оживит» поведенческие метрики.

P.S. Если ваш сайт уже попал под фильтр — не паникуйте! Пишите в комментариях, расскажу, как подать пересмотр в Google через инструмент для вебмастеров.

Оптимизируем не трафик, а ценность — пока ИИ не научился читать мысли!